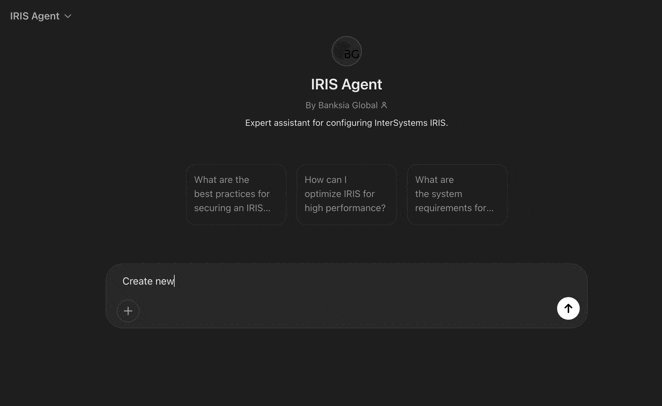

J'ai un nouveau projet qui consiste à stocker des informations provenant de réponses REST dans une base de données IRIS. Il me faudra synchroniser les informations provenant d'au moins deux douzaines de points de terminaison REST distincts, ce qui implique la création de presque autant de classes ObjectScript pour stocker les résultats de ces points de terminaison.

Puis-je utiliser ChatGPT pour créer ces classes? La réponse est "Oui", ce qui est génial puisqu'il s'agit de ma première tentative d'utiliser l'IA générative pour quelque chose d'utile. En effet, générer des images de girafes mangeant de la soupe devenait un peu vieux….

Voici ce que j'ai fait:

- Obtenez un exemple de sortie d'appel REST JSON en utilisant "curl" pour interroger le point de terminaison.

- Visitez ChatGPT (InterSystems fournit une licence à l'échelle de l'entreprise pour les employés)

- Accédez au dialogue suivant avec ChatGPT.

J'ai placé la demande suivante dans la fenêtre de message de ChatGPT:

Moi: Générer une classe ObjectScript qui contiendra les données du JSON suivant:

J'ai appuyé sur "Return" avant d'entrer le JSON et ChatGPT m'a donc dirigé comme suit:

ChatGPT: Veuillez fournir la structure JSON pour laquelle vous souhaitez que je génère la classe ObjectScript. Si vous avez un exemple d'objet JSON, collez-le ici et je créerai pour vous la classe ObjectScript InterSystems correspondante.

J'ai saisi ce qui suit dans la fenêtre de message:

{

"id": 335818632,

"appId": 113,

"appName": "Batch",

"contentId": 182455380233,

"subject": "Test Subject",

"name": "Test email campaign name",

"counters": {

"processed": 3910,

"deferred": 86,

"unsubscribed": 17,

"statuschange": 17,

"bounce": 153,

"mta_dropped": 8,

"dropped": 299,

"delivered": 3749,

"sent": 3903,

"click": 16,

"open": 323

},

"lastProcessingFinishedAt": 1733232499000,

"lastProcessingStartedAt": 1733232303000,

"lastProcessingStateChangeAt": 1733232499000,

"numIncluded": 4201,

"processingState": "DONE",

"scheduledAt": 1733232300000,

"type": "BATCH_EMAIL"

}

Réponse de ChatGPT:

Voici la classe ObjectScript InterSystems qui correspond à la structure JSON fournie:

Class MyNamespace.MyJSONData Extends (%Persistent, %JSON.Adaptor)

{

Property id As%IntegerProperty appId As%IntegerProperty appName As%StringProperty contentId As%IntegerProperty subject As%StringProperty name As%StringProperty counters As MyNamespace.CountersProperty lastProcessingFinishedAt As%BigIntProperty lastProcessingStartedAt As%BigIntProperty lastProcessingStateChangeAt As%BigIntProperty numIncluded As%IntegerProperty processingState As%StringProperty scheduledAt As%BigIntProperty type As%StringClassMethod%OnJSONImport(jsonObject As%Object, instance As MyNamespace.MyJSONData) As%Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyNamespace.Counters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As%IntegerProperty deferred As%IntegerProperty unsubscribed As%IntegerProperty statuschange As%IntegerProperty bounce As%IntegerProperty mta_dropped As%IntegerProperty dropped As%IntegerProperty delivered As%IntegerProperty sent As%IntegerProperty click As%IntegerPropertyopenAs%Integer

}

Avec une explication:

.png)

Ce code est un bon départ, mais j'aimerais qu'il s'intègre dans mon paquetage nommé “MyPkg” et que la classe porte le nom “EmaiCampaign”. De plus, grâce à mes connaissances en NI, je sais que les valeurs qui ont généré les propriétés “%BigInt” sont en fait des horaires Linux et que les propriétés devraient être %Library.PosixTime”.

Je fais la demande suivante (je ne sais pas trop pourquoi je dis "s'il vous plaît" à une machine; je suppose que mes parents ont fait du bon travail):

Moi: Pouvons-nous recréer la classe, s'il vous plaît, en renommant le paquetage " MyPkg" et la classe "EmailCampaign"? De plus, veuillez changer les types de propriétés de %BigInt à %Library.PosixTime.

Reponse de ChatGPT:

Voici la classe ObjectScript mise à jour avec le nom de paquetage et le nom de classe spécifiés, et les propriétés d'horodatage mises à jour pour l'utilisation de %Library.PosixTime:

Class MyPkg.EmailCampaign Extends (%Persistent, %JSON.Adaptor)

{

Property id As%IntegerProperty appId As%IntegerProperty appName As%StringProperty contentId As%IntegerProperty subject As%StringProperty name As%StringProperty counters As MyPkg.CountersProperty lastProcessingFinishedAt As%Library.PosixTimeProperty lastProcessingStartedAt As%Library.PosixTimeProperty lastProcessingStateChangeAt As%Library.PosixTimeProperty numIncluded As%IntegerProperty processingState As%StringProperty scheduledAt As%Library.PosixTimeProperty type As%StringClassMethod%OnJSONImport(jsonObject As%Object, instance As MyPkg.EmailCampaign) As%Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyPkg.Counters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As%IntegerProperty deferred As%IntegerProperty unsubscribed As%IntegerProperty statuschange As%IntegerProperty bounce As%IntegerProperty mta_dropped As%IntegerProperty dropped As%IntegerProperty delivered As%IntegerProperty sent As%IntegerProperty click As%IntegerPropertyopenAs%Integer

}

Avec une explication suivante:

.png)

Après avoir copié le code "tel quel" dans VSCode, des problèmes de syntaxe avec les accolades ont été mis en évidence. Les classes ObjectScript ne permettent pas de définir des classes internes.

.png)

Demander à ChatGPT de résoudre le problème des « accolades » en faisant de la classe interne MyPkg.Counters une classe séparée est une opération impossible “no-op”; un humain devra déplacer cette classe dans un autre fichier. ChatGPT a renommé cette classe après la demande suivante:

Moi: La classe telle qu'elle est écrite ne compile pas. Pouvons-nous déplacer la classe interne nommée MyPkg.Counters de la classe principale vers sa propre classe et la renommer en MyPkg.CampaignCounters?

Reponse de ChatGPT:

Voici le code ObjectScript mis à jour avec la classe MyPkg.CampaignCounters déplacée comme sa propre classe:

Class MyPkg.EmailCampaign Extends (%Persistent, %JSON.Adaptor)

{

Property id As%IntegerProperty appId As%IntegerProperty appName As%StringProperty contentId As%IntegerProperty subject As%StringProperty name As%StringProperty counters As MyPkg.CampaignCountersProperty lastProcessingFinishedAt As%Library.PosixTimeProperty lastProcessingStartedAt As%Library.PosixTimeProperty lastProcessingStateChangeAt As%Library.PosixTimeProperty numIncluded As%IntegerProperty processingState As%StringProperty scheduledAt As%Library.PosixTimeProperty type As%StringClassMethod%OnJSONImport(jsonObject As%Object, instance As MyPkg.EmailCampaign) As%Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyPkg.CampaignCounters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As%IntegerProperty deferred As%IntegerProperty unsubscribed As%IntegerProperty statuschange As%IntegerProperty bounce As%IntegerProperty mta_dropped As%IntegerProperty dropped As%IntegerProperty delivered As%IntegerProperty sent As%IntegerProperty click As%IntegerPropertyopenAs%Integer

}

Après avoir collé ce qui précède dans VSCode et l'avoir compilé, le compilateur a signalé que le type nommé "%Object" n'existe pas dans ObjectScript. v %JSONImport() de %JSON.Adaptor est flexible:

“L'argument d'entrée est soit JSON en tant que chaîne ou flux, soit une sous-classe de %DynamicAbstractObject.”

Après avoir supprimé la propriété "As %Object" pour le premier paramètre de %OnJSONImport() dans la première classe et avoir séparé les deux classes dans des fichiers distincts, la classe MyPkg.EmailCampaign s'est compilée avec succès. Cependant, la classe MyPkg.CampaignCounters ne s'est pas compilée ; ChatGPT ne sait pas (pour l'instant ?) que l'underscore est un caractère spécial en ObjectScript (l'opérateur de concaténation de chaînes de caractères).

Essayons de le lui enseigner.

Moi: Le caractère underscore "_" est un caractère spécial dans ObjectScript. Veuillez changer les propriétés dont le nom contient un underscore en camel case et supprimer l'underscore.

Reponse de ChatGPT:

Voici le code mis à jour avec les propriétés qui avaient des underscores dans leurs noms convertis en camel case:

Class MyPkg.EmailCampaign Extends (%Persistent, %JSON.Adaptor)

{

Property id As%IntegerProperty appId As%IntegerProperty appName As%StringProperty contentId As%IntegerProperty subject As%StringProperty name As%StringProperty counters As MyPkg.CampaignCountersProperty lastProcessingFinishedAt As%Library.PosixTimeProperty lastProcessingStartedAt As%Library.PosixTimeProperty lastProcessingStateChangeAt As%Library.PosixTimeProperty numIncluded As%IntegerProperty processingState As%StringProperty scheduledAt As%Library.PosixTimeProperty type As%StringClassMethod%OnJSONImport(jsonObject As%Object, instance As MyPkg.EmailCampaign) As%Status

{

Quit ..%JSONImport(jsonObject, .instance)

}

}

Class MyPkg.CampaignCounters Extends (%SerialObject, %JSON.Adaptor)

{

Property processed As%IntegerProperty deferred As%IntegerProperty unsubscribed As%IntegerProperty statusChange As%IntegerProperty bounce As%IntegerProperty mtaDropped As%IntegerProperty dropped As%IntegerProperty delivered As%IntegerProperty sent As%IntegerProperty click As%IntegerPropertyopenAs%Integer

}

Avec une explication suivante:

.png)

ChatGPT s'est surpassé et a changé une autre propriété, nommée avec deux mots distincts, en camel case également (statuschange); je garde ce changement puisque d'autres propriétés nommées de la même manière dans la classe principale sont toutes en camel case.

Avec le dernier code généré dans deux fichiers séparés (et en supprimant la définition "As %Object" dans la définition de la méthode %OnJSONImport()), tout le code se compile avec succès.

Ces classes générées sont un excellent point de départ pour ce dont j'ai besoin et je répéterai le processus pour les autres sources de données REST de ce projet, ce qui me permettra d'éviter de nombreuses saisies inutiles.

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)